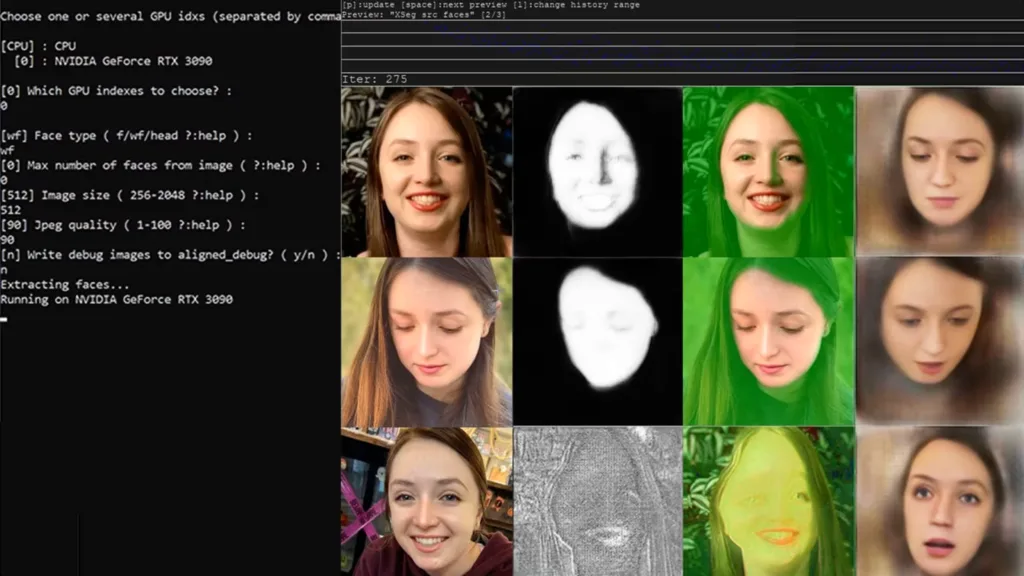

Соцмережу Х (раніше Twitter) нещодавно заполонили фейкові відверті фотографії американської співачки Тейлор Свіфт. Через обурення фанатів зірки та потужний суспільний розголос платформа видалила підробку. Проте навіть на діпфейк (deepfake — методика синтезу зображення людини, яка базується на штучному інтелекті — прим.ред.) за участю відомої особистості соцмережа відреагувала настільки повільно, що зображення набрало 47 мільйонів переглядів.

На звернення більшості жінок, які постраждали від створення та розповсюдження фейкових сексуальних зображень без їхньої згоди та відвертих діпфейків, медіаплатформи реагують ще повільніше. Зокрема, 17-річна зірка серіалу «Доктор Стрендж у мультивсесвіті божевілля» Сочіл Гомес заявила, що не змогла домогтися видалення своїх підроблених зображень, пише The Guardian.

Активістка і дослідниця технічної та політичної лабораторії Університету Західної Австралії Ноель Мартін вперше виявила своє обличчя на сексуальних зображеннях та діпфейках 11 років тому.

За словами жінки, спочатку це були її підроблені фотографії, але в останні кілька років, час активного поширення штучного інтелекту, з’явилися відео, які переважно розповсюджуються на порнографічних сайтах.

Мартін зазначила, що навіть якщо зображення не дуже реалістичні, «цього все одно достатньо, щоб завдати непоправної шкоди людині», адже це впливає на все — «від вашого працевлаштування, вашої майбутньої здатності заробляти, до ваших стосунків, це те, про що потрібно говорити на перших побаченнях, це зазіхає на кожен аспект вашого життя».

«Це неминуча форма насильства, що має наслідки, які діють вічно. Зняття та видалення — це марний процес. Це важка битва, і ви ніколи не можете гарантувати повного видалення, коли щось з’являється», — додала жінка.

Дослідження 2019 року, проведене компанією з кібербезпеки Deeptrace, показало, що 96% діпфейкового відеоконтенту в онлайні були порнографією, використовуваною без згоди.

На думку англійської письменниці Лори Бейтс, авторки книжки «Чоловіки, які ненавидять жінок» про спільноти жінконенависників, це «просто новий спосіб контролю над жінками».

«Ви берете таку людину, як Свіфт, котра є надзвичайно успішною та сильною, і це спосіб повернути її назад. Це спосіб сказати будь-якій жінці: “Неважливо, хто ти, наскільки ти сильна — ми можемо звести тебе до сексуального об’єкта, і ти нічого з цим не поробиш”», — пояснила вона.

Старша співробітниця з питань політики та зв’язків з громадськістю британської благодійної організації Національне товариство запобігання жорстокому поводженню з дітьми (NSPCC) Рані Говендер наголосила, що «це проблема, яка має абсолютний вплив на молодь».

«Подібно до інших форм сексуального насильства на основі зображень, це особливо впливає на дівчат. Це розсилають по школах і використовують як форму сексуальних домагань і знущань. Страх — це тема, яка часто виникає: хвилювання, що люди подумають, що це реальність, що це може призвести до подальших сексуальних домагань і знущань. [Є] занепокоєння щодо того, що можуть подумати їхні батьки», — зауважила вона.

Зокрема, торік до консультаційної служби ChildLine NSPCC звернулась 14-річна дівчина, яка розповіла, що група хлопців створила підроблені відверто сексуальні зображення низки дівчат та розіслали їх у групові чати. Хлопців на деякий час виключили зі школи, але згодом повернули, а дівчатам сказали «рухатися далі», що їм було важко зробити.

Також штучний інтелект можуть використовувати для створення зображень сексуального насильства над дітьми, щоб шантажувати та погрожувати дітям або продавати порнографічний контент.

«Існує велика проблема щодо того, скільки відвертих і порнографічних матеріалів легко доступні дітям на сайтах соціальних мереж. Якщо створювати та ділитися цим матеріалом стане легше, це матиме справді негативний вплив на погляди дітей щодо серйозності цих зображень», — додала експертка.

У 2023 році творці фільму Another Body про американську студентку, яка шукає справедливості після того, як виявила в інтернеті фейкову порнографію з її фото, започаткували кампанію My Image My Choice. Після цього до співрежисерки стрічки Софі Комптон почали масово звертатися жінки, які постраждали від діпфейків.

«Те, що ми бачили за останні декілька років, — це розвиток цієї спільноти, яка була досить маргінальною й темною та інтенсивно входила в мейнстрим справді тривожним чином», — сказала вона.

Один із дослідників компанії Deeptrace Генрі Айдер виявив у Telegram спільноти, «де генерувалися сотні тисяч порнографічних зображень». За його словами, люди, які використовують програмне забезпечення з відкритим кодом, на відміну від інструментів штучного інтелекту, таких як Dall-E 3 або Midjourney, навчених забороняти порнографічний вміст, можуть по суті створювати те, що їм подобається, включаючи екстремальні та жорстокі фантазії, втілені в життя.

Проте, на думку Айдера, важливим моментом у ситуації з Тейлор Свіфт є розуміння, що тепер зловмисники можуть практично безперешкодно публікувати свій контент на відкритих популярних платформах соціальних мереж, а не на спеціалізованих сайтах фейкової порнографії, як це було раніше.

«Можна з упевненістю припустити, що переважна більшість — чоловіки. Я думаю, що багато людей, які орієнтуються на знаменитостей, роблять це заради сексуального задоволення. Це часто супроводжується жінконенависницькими висловлюваннями — це може бути сексуальне задоволення, але воно дуже сильно поєднується з деякими досить жахливими поглядами на жінок. Це також використовувалося для нападу на жінок-політиків, щоб спробувати змусити їх замовкнути та залякати. Це справді демонструє багато проблем, з якими жінки вже стикаються, але дає абсолютно нову та дуже потужну зброю для дегуманізації та об’єктивізації», — заявив він.

Айдер висловив сподівання, що діпфейки зі Свіфт можуть стати «каталізатором значущих законодавчих змін».

«Сумно, що одна з найбільших знаменитостей у світі стала мішенню для того, щоб люди визнали, наскільки це велика проблема. Якщо ви створюєте, ділитеся або використовуєте такий вміст, ви фактично є сексуальним злочинцем. Ви вчиняєте сексуальний злочин проти іншої людини», — сказав експерт.

Окрім цього, Айдер зауважив, що із прискоренням розвитку віртуальної реальності зростатиме й можливість сексуального насильства в ній. Зокрема, штучний інтелект вже може відтворювати голос людини, і це також можна використати для маніпуляції.

Відповідно до нового закону Великої Британії про безпеку в Інтернеті, розповсюдження фейкових порнографічних матеріалів без згоди є незаконним, проте на створення таких зображень закон не поширюється.

«Багато років уряд вважав, що шкода від фальшивих зображень незначна, хоча, звичайно, вони просто стверджували це, фактично не спілкуючись із жертвами. Це ширша проблема насильства в інтернеті щодо жінок і дівчат, яку не сприймають серйозно. Люди не розуміють, що шкода від цього може бути глибокою та руйнівною, постійною та безперервною — це не відбувається просто так, і ви можете спробувати подолати це та продовжувати своє життя. Ймовірно, воно завжди буде в інтернеті й завжди з’являтиметься знову», — зазначила професорка права Даремського університету та експертка зі зловживань за допомогою зображень Клер МакГлінн.

- Нещодавно аналітична компанія Graphika повідомила, що застосунки та вебсайти, що використовують штучний інтелект для створення фейкових оголених зображень жінок, стають дедалі популярнішими. За результатами дослідження, від початку 2023 року кількість коментарів і публікацій з посиланнями на ці ресурси лише на Reddit і X зросла на понад 2000% — з 1280 у 2022 році до понад 32 100.

- Раніше журналісти BBC з’ясували, що технологію штучного інтелекту використовують для створення та продажу дитячого порно у промислових масштабах, зокрема контенту з реалістичним зображенням сексуального насильства над дітьми, і навіть зґвалтування немовлят і дітей раннього віку.

- Тим часом британська поліція вже розслідує перший випадок зґвалтування у віртуальній реальності. За даними слідства, «аватар» дівчини, якій ще не виповнилося 16 років, — її цифрове зображення — зазнав групового «сексуального нападу» з боку незнайомців у метавсесвіті, коли вона грала онлайн у VR-гру.

- DIVOCHE.MEDIA розповідало, куди звертатися по допомогу у випадку, якщо людина постраждала від інтернет-насильства.

Фото: ThisIsEngineering: Pexels